Vivimos en una época donde lo que vemos ya no siempre es lo que es. El surgimiento de los deepfakes, vídeos y audios generados o modificados mediante inteligencia artificial (IA) para suplantar rostros, voces y movimientos, ha abierto la puerta a una nueva forma de manipulación masiva: la suplantación digital.

Ya no se trata solo de noticias falsas en texto o imágenes editadas; ahora, con unas pocas muestras de voz y algunas fotos, cualquier persona puede ser replicada digitalmente de forma inquietantemente realista. Y eso plantea riesgos enormes tanto para usuarios individuales como para empresas.

¿Qué son los deepfakes y cómo funcionan?

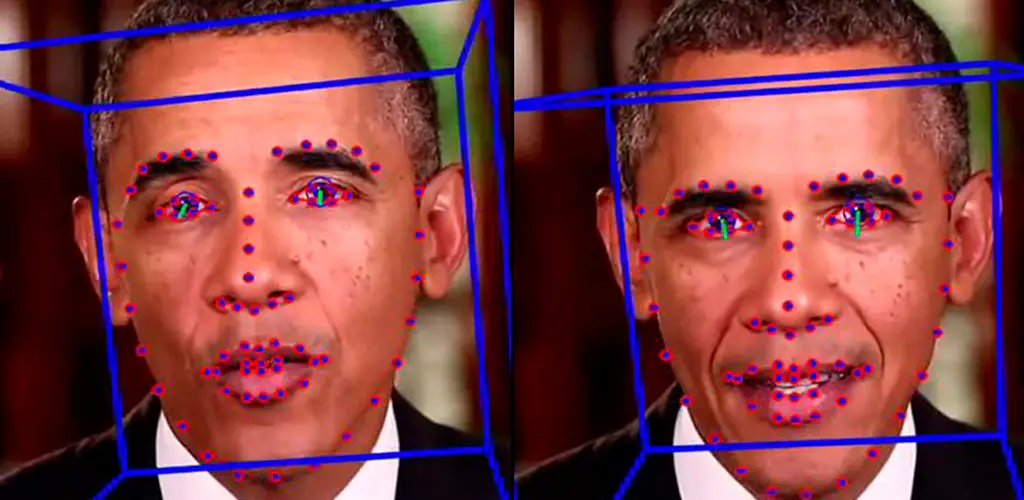

Los deepfakes (combinación de “deep learning” y “fake”) son contenidos sintéticos manipulados que simulan con extrema fidelidad el comportamiento humano. Gracias a algoritmos de aprendizaje profundo, una IA puede aprender a replicar los movimientos faciales, el tono de voz, la expresión e incluso los gestos más sutiles de una persona.

Esto se logra principalmente mediante dos tecnologías:

Redes Generativas Antagónicas (GANs): un tipo de red neuronal que aprende a generar datos falsos a partir de datos reales.

Modelos de síntesis de voz (text-to-speech): que permiten clonar la voz de una persona con apenas unos minutos de grabación.

En conjunto, estas herramientas permiten crear vídeos en los que una persona parece decir o hacer algo que nunca ocurrió. Y el resultado puede ser tan realista que, sin contexto o herramientas de verificación, es casi imposible distinguirlos.

El papel de la inteligencia artificial en la creación de contenido falso

La IA es la responsable de que los deepfakes hayan evolucionado de ser un truco visual rudimentario a convertirse en contenidos hiperrealistas. Lo que antes requería un equipo de efectos especiales ahora se puede lograr con software accesible y conocimientos técnicos medios.

Existen plataformas y herramientas de código abierto que permiten a cualquier usuario entrenar modelos con videos disponibles en línea. Esto ha hecho que la creación de contenido falso se haya democratizado peligrosamente.

Además de los deepfakes en vídeo, la IA también puede:

Imitar voces mediante generadores de audio.

Crear imágenes realistas de personas que no existen.

Generar chats falsos, simulando conversaciones reales.

Imitar firmas digitales o gestos capturados por cámaras de seguridad.

La automatización del engaño es ya una realidad. Y con cada avance tecnológico, la línea entre lo real y lo fabricado se difumina aún más.

Deepfakes y suplantación digital: ¿qué tan grave es el problema?

Lo preocupante no es solo la tecnología, sino su uso malicioso. La suplantación digital mediante deepfakes se ha convertido en una herramienta poderosa para:

Extorsiones: crear vídeos comprometidos falsos para chantajear.

Fraudes empresariales: suplantar a directivos para ordenar transferencias bancarias.

Desinformación: difundir mensajes falsos atribuidos a figuras públicas.

Ciberacoso: modificar vídeos íntimos para avergonzar a una persona.

El informe de ISMS Forum advierte que esta tecnología está siendo utilizada cada vez más en ataques dirigidos y fraudes sofisticados. La facilidad con la que se pueden generar estos contenidos hace que sea muy difícil responder a tiempo.

Peor aún: el daño reputacional es muchas veces irreversible, incluso si se demuestra que el contenido es falso. Una vez que algo se viraliza, desmentirlo no borra su impacto emocional ni las consecuencias sociales o económicas que conlleva.

Casos reales de engaños digitales con deepfakes

No se trata de un riesgo futuro. Ya hay múltiples casos documentados que ilustran cómo los deepfakes están siendo usados hoy en día para manipular, engañar y defraudar.

Fraude financiero en Reino Unido: en 2020, un CEO recibió una llamada de su “jefe”, quien le pidió que realizara una transferencia urgente. La voz era generada por IA y clonaba el acento y tono de su superior. El engaño costó más de 240 mil dólares.

Extorsiones con contenido íntimo falso: varias personas han denunciado haber sido víctimas de chantajes tras recibir vídeos explícitos donde aparece su rostro montado en otro cuerpo. Aunque sean falsos, las consecuencias psicológicas son devastadoras.

Manipulación en redes sociales: se han detectado campañas en las que influencers ficticios —creados por IA— difunden información falsa, promocionan productos o incitan a comportamientos de riesgo.

Estos casos demuestran que la suplantación digital ya no es ciencia ficción. Es una amenaza real, y en muchos casos, invisible hasta que el daño ya está hecho.

Los riesgos para empresas y usuarios individuales

El impacto de los deepfakes no se limita a celebridades o figuras públicas. Cualquier persona puede ser víctima, especialmente en entornos empresariales o con acceso a datos sensibles.

| Riesgos para Empresas | Riesgos para Usuarios Individuales |

|---|---|

| Pérdida de confianza de clientes o inversores por fraudes mediáticos. | Robo de identidad digital a partir de fotos y vídeos en redes sociales. |

| Accesos no autorizados a sistemas mediante suplantación en videollamadas. | Engaños sentimentales con identidades falsas generadas por IA. |

| Desinformación interna que afecte decisiones estratégicas. | Manipulación emocional o psicológica con vídeos o audios falsos. |

| Daño a la reputación corporativa por deepfakes de directivos. | Daño a la integridad y reputación personal, incluso con pruebas falsas. |

Cómo detectar deepfakes: ¿es posible distinguir lo real de lo falso?

Detectar un deepfake con los propios sentidos es cada vez más difícil. La calidad de estos vídeos ha mejorado tanto que incluso expertos en edición pueden ser engañados.

Sin embargo, existen algunas señales que pueden ayudar a identificarlos:

Parpadeos poco naturales o falta de expresividad ocular.

Movimientos labiales desincronizados con el audio.

Sombras inconsistentes o reflejos imposibles en gafas y superficies.

Textura de piel inusualmente suave o sin imperfecciones.

Errores de iluminación cuando se insertan rostros en entornos reales.

Además, ya se están desarrollando algoritmos anti-deepfake, capaces de identificar patrones de manipulación en el vídeo o el audio. Plataformas como YouTube o Meta están implementando estas tecnologías, aunque todavía con limitaciones.

A nivel usuario, la verificación de fuentes, el contexto del contenido y el escepticismo crítico siguen siendo las herramientas más efectivas.

| Señal de Alerta | Descripción | Fiabilidad como Indicador |

|---|---|---|

| Parpadeo poco natural | Ojos que parpadean con muy poca frecuencia o de forma robótica. | Alta |

| Movimientos labiales desincronizados | La voz y el movimiento de los labios no coinciden exactamente. | Alta |

| Sombras inconsistentes | Sombras y reflejos que no corresponden con la iluminación del entorno. | Media |

| Textura de piel irreal | Piel demasiado lisa, sin poros ni imperfecciones naturales. | Media |

| Errores de iluminación | Luz que no coincide con la escena o cambios bruscos de tonalidad. | Media |

El vacío legal y los desafíos regulatorios ante los deepfakes

Uno de los problemas más serios frente a los deepfakes es que la legislación va muy por detrás de la tecnología.

En muchos países, no existe una figura legal clara para perseguir a quien crea o difunde un deepfake dañino. Y aunque se logre identificar al responsable, los procesos judiciales suelen ser lentos y poco efectivos para reparar el daño causado.

Entre los desafíos legales más urgentes:

Definir la suplantación digital como delito específico.

Establecer sanciones claras por la creación y distribución de deepfakes con fines maliciosos.

Obligar a las plataformas a etiquetar contenidos sintéticos o sospechosos.

Facilitar la eliminación rápida de estos contenidos y el derecho al olvido digital.

Europa ha empezado a trabajar en marcos regulatorios sobre IA, pero aún estamos lejos de un consenso global que proteja efectivamente a las personas frente al abuso de esta tecnología.

Estrategias de prevención y protección frente a la suplantación digital

La mejor defensa sigue siendo la prevención. Aquí algunas recomendaciones prácticas para usuarios y empresas:

| Medidas para Usuarios | Medidas para Empresas | Impacto Esperado |

|---|---|---|

| Limitar fotos y vídeos públicos en redes sociales. | Protocolos de verificación para transacciones y comunicaciones internas. | Reduce la probabilidad de ser suplantado visual o auditivamente. |

| Configurar privacidad en todas las plataformas digitales. | Formación de empleados sobre riesgos de contenido manipulado. | Disminuye la exposición y el riesgo de engaños dirigidos. |

| Verificar contenido antes de compartirlo. | Uso de herramientas de detección de deepfakes en entornos críticos. | Minimiza la difusión de contenido falso y protege la reputación. |

| Aprender a identificar patrones visuales sospechosos. | Estrategias de gestión de crisis para fraudes digitales. | Mejora la capacidad de reacción ante un ataque. |

Además, invertir en ciberseguridad emocional, es decir, educación digital crítica es igual de importante que cualquier software. Saber que este tipo de ataques existen ayuda a desarrollar una respuesta más rápida y menos ingenua.

El futuro del engaño digital: ¿hasta dónde puede llegar esta tecnología?

La evolución de los deepfakes no se detendrá. De hecho, se espera que sean aún más realistas, accesibles y automatizados.

Algunos escenarios futuros incluyen:

Deepfakes en tiempo real durante videollamadas.

Identidades digitales enteramente fabricadas, imposibles de rastrear.

Fraudes con IA que simulan conversaciones completas en plataformas de voz.

Ataques masivos coordinados para desinformar a gran escala.

Pero también hay esperanza. La misma IA que crea estos contenidos puede ser usada para detenerlos. Investigadores y empresas están desarrollando herramientas defensivas capaces de identificar manipulaciones casi invisibles para el ojo humano.

Lo importante es no quedarse atrás. La velocidad con la que avanza esta tecnología exige que gobiernos, plataformas y ciudadanos se preparen para una nueva realidad donde la verdad visual y auditiva ya no es absoluta.

Conclusión: la batalla por la verdad en la era de la inteligencia artificial

Los deepfakes representan el lado más inquietante de la inteligencia artificial. Han demostrado que la verdad puede ser fabricada con una fidelidad casi perfecta. Y eso nos obliga a redefinir la forma en que confiamos en lo que vemos y escuchamos.

Pero la tecnología no es buena ni mala por sí sola. Depende de cómo decidamos usarla. Ante este nuevo desafío digital, necesitamos una combinación de legislación, educación, herramientas tecnológicas y conciencia colectiva.

La suplantación digital no es solo un problema técnico, es un fenómeno cultural, social y ético. Y enfrentarlo requiere que todos —usuarios, empresas, educadores y desarrolladores— participemos activamente en la defensa de la verdad.

Porque si todo puede ser falsificado, lo más valioso será saber cómo distinguir lo auténtico.